ChatGPT에게 한국 역사를 물어보다 - 한계 편

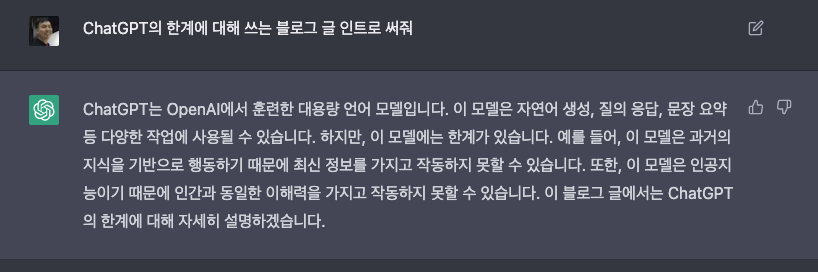

ChatGPT에게 “ChatGPT의 한계에 대해 쓰는 블로그 글 인트로 써줘”라고 했더니 이러한 답이 나왔습니다.

ChatGPT는 OpenAI에서 훈련한 대용량 언어 모델입니다. 이 모델은 자연어 생성, 질의 응답, 문장 요약 등 다양한 작업에 사용될 수 있습니다. 하지만, 이 모델에는 한계가 있습니다. 예를 들어, 이 모델은 과거의 지식을 기반으로 행동하기 때문에 최신 정보를 가지고 작동하지 못할 수 있습니다. 또한, 이 모델은 인공지능이기 때문에 인간과 동일한 이해력을 가지고 작동하지 못할 수 있습니다. 이 블로그 글에서는 ChatGPT의 한계에 대해 자세히 설명하겠습니다.

곧 저 같은 블로거를 대체할 수 있을까요? 😂

지난 글에서 ChatGPT의 원리를 공부하였습니다. 정말 놀라운 답변 생성 능력을 보여주지요. 하지만 자백하듯이 ChatGPT는 한계를 가지고 있습니다.

“최신 정보를 가지지 않는다, 그리고 인간과 동일한 이해력을 가지지 않는다”

그런데 제가 생각하는 가장 중요한 한계에 대해서는 언급하지 않습니다. 역시 자기 성찰은 어려운 것이군요. 그 외에는 어떤 한계가 있을까요?

이를 알아보기 위해 이번에는 ChatGPT에게 한국 역사에 대해 물어보며 글을 써보았습니다.

2002년 봄을 기억하시나요?

제 인생에서 가장 온몸으로 느낀 역사적 사건은 2002년 월드컵이었습니다. 당시 매일 운동장에서 공을 차러 나갔던 초등학생이었던 저는 그 때의 기억이 생생합니다. 그리고 스포츠 채널에서는 월드컵 경기 하이라이트를 거의 몇 년간 틀어주었기에 경기 내용도 전부 외우고 있습니다.

독자 분들께서는 어떻게 기억하고 계신가요? (몇몇 독자 분들은 너무 어리거나 이후에 태어나셨을 수도 있겠네요..!)

ChatGPT에게 2002년 월드컵에 대해 묻다

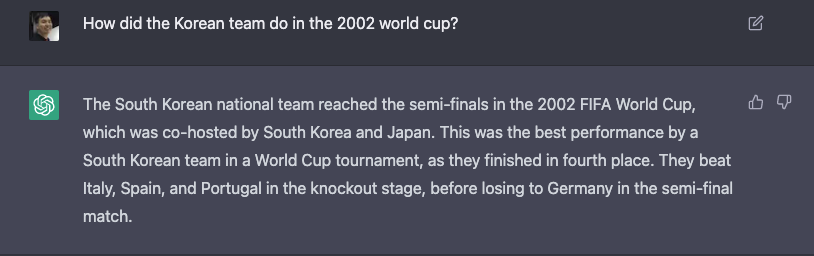

Jiho: 한국 팀은 2002년 월드컵에서 어땠니?

ChatGPT: 대한민국 대표팀은 한국과 일본이 공동 주최한 2002 피파 월드컵에서 준결승전까지 진출했어. 4위로 마무리되었고, 이게 대한민국 팀이 역대 월드컵에서 이룬 최고의 성과지. 토너먼트에서 이탈리아, 스페인, 포르투갈을 이기다가 준결승전에서 독일에게 졌어.

오, 역시 잘 알고 있군요. 하지만 기억력이 좋으신 분들은 여기서 단 한 가지 오류가 있다는 것을 알아채셨을 겁니다. 다시 한번 읽어 보실까요?

벤투 감독이 뛰었던 포르투갈은 조별리그 3차전에서 한국에게 지고 2002년 토너먼트 진출에 실패하였다는 것입니다.

“뭐 이 정도 실수야 할 수 있지 않겠어? 포르투갈은 워낙 강팀이니깐 나도 헷갈렸겠네.”라고 생각할 수도 있겠네요.

더 이어서 물어보겠습니다.

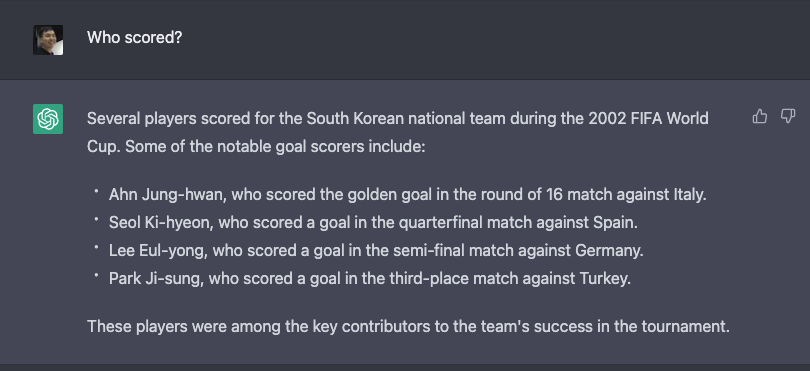

Jiho: 골은 누가 넣었니?

ChatGPT: 여러 명이 넣었지. 몇몇 골을 소개하자면:

이탈리아와의 16강전의 골든볼을 넣은 안정환,

스페인과의 8강전에서 골을 넣은 설기현,

독일과의 4강전에서 골은 넣은 이을용,

터키와의 3,4위전에서 골을 넣은 박지성

이 선수들은 한국 팀의 토너먼트에서 성공을 이끌었어.

안정환, 설기현, 이을용, 박지성 선수 모두 월드컵에서 골을 넣었죠. 하지만 여기서 정확한 내용은 안정환의 골든볼 뿐입니다. 설기현는 이탈리아전에서 동점골을, 이을용은 터키전에서 멋진 프리킥 골을, 박지성은 위에 언급된 포르투칼 전에서 골을 넣었죠! 독일 전은 한골도 넣지 못했습니다.

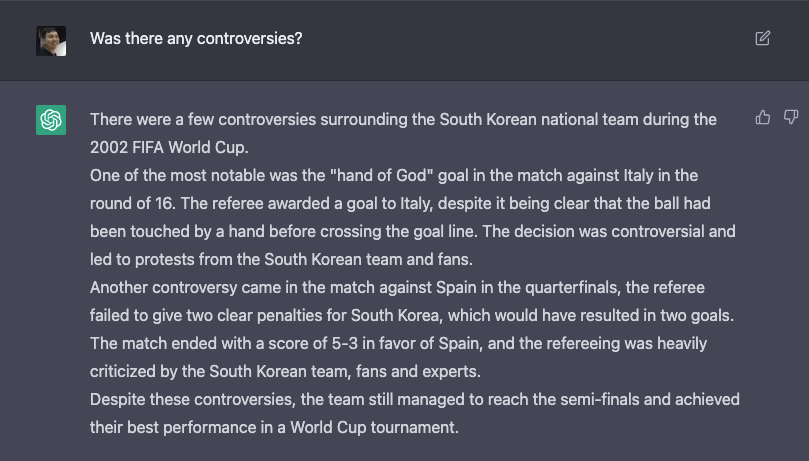

Jiho: 논란거리는 없었니?

ChatGPT: 대한민국 대표팀에 대한 여러가지 논란이 있었지. 가장 컸던 건 이탈리아 전에 “신의 손" 골이야. 심판은 분명히 공이 골라인을 넘어가기전에 손에 닿았는데도 이탈리아에게 골을 주었지. 이 결정은 한국 팬들에게 무척 논란거리가 되어 시위까지 일어났어.

다른 논란거리는, 스페인에서의 준준결승전 때, 심판이 당연한 한국에게 페널티킥을 두번 주지 않았어. 결국 스페인은 5-3으로 승리하며 끝났고, 심판은 많은 한국 선수, 팬, 전문가에게 비판 받았어.

그럼에도 불구하고 대한민국 팀은 준결승에 진출하였고 월드컵 역대 최고 성적을 냈어.

ChatGPT가 정신줄을 놓아버렸습니다. “신의 손" 사건은 1986년 마라도나의 월드컵 골을 지칭하는 사건인데 대한민국과 이탈리아와의 16강 전에 연동시켰습니다.

그리고 스페인과의 8강전은 득점이 없이 끝났고, 결국 승부차기에서 이운재의 멋진 선방으로 5-3으로 승리했었죠! 하지만 답변에서는 스페인이 이겼다고 하네요. 그럼에도 불구하고 다음 라운드로 진출한 대한민국 팀..? 이러한 팩트의 조각들은 아주 그럴듯하게 섞어 답변을 생성했습니다..

마지막으로 물어보았습니다.

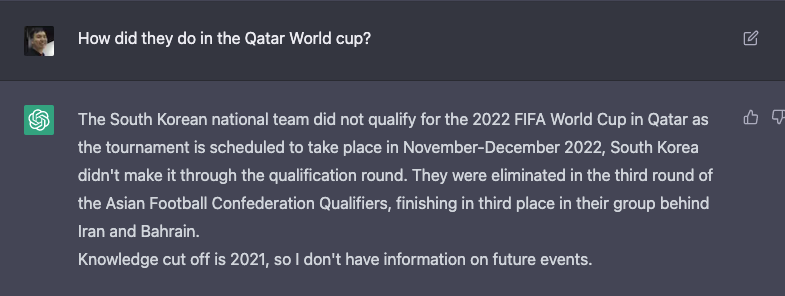

Jiho: 카타르 월드컵에서는 어땠어?

ChatGPT: 대한민국 대표팀은 11,12월에 열릴 2022 카타르 월드컵에 진출하지 못했어. 아시아 지역 예선에서 이란과 바레인에 밀리며 3위를 하고 예선 탈락했지. 내 지식은 2021년까지라 그 이후에는 어떻게 된지는 모르겠다.

더이상 설명하지 않도록 하겠습니다.

ChatGPT의 명백한 한계 그리고 위험성

위 예시를 보시면서 ChatGPT가 어떤 한계를 가졌는지 느끼셨을겁니다. 바로 사실 관계와 상관 없이 그럴듯한 문장을 지어낸다는 것인데요.

이를 언어 모델의 Hallucination이라고 부릅니다. 한국어로 번역하면 “착각", “환영”, “환청”, 즉 세상에 존재하지 않는 것을 보거나 듣는다는 뜻인데, ChatGPT는 눈이나 귀는 없고 입만 있는 셈이니, ChatGPT의 결과물을 읽는 우리 인간들의 관점에서 착각을 뜻하는 용어죠.

문제는 그저 그럴듯한 것 아니라 굉장히 잘 쓰여진 문장을 구사한다는 것입니다. 심지어 과학자들도 ChatGPT가 쓴 가짜 논문 초록을 걸러내지 못했다는 연구가 있습니다. 이렇게 사실적인 글을 생성할 수 있기에 어떤 이들은 이러한 모델을 공개해 버린 OpenAI를 비난하며 ChatGPT를 “바이러스” 또는 “핵폭탄"으로 묘사하기도 합니다. 안그래도 가짜 뉴스가 판치는 인터넷을 더 오염시킬 괴수를 풀어놨다는 지적이죠.

물론 ChatGPT가 항상 사실 관계를 파악 못하는 것은 아닙니다. 꽤나 뛰어난 논리력으로 사실 관계를 알려주기도 합니다.

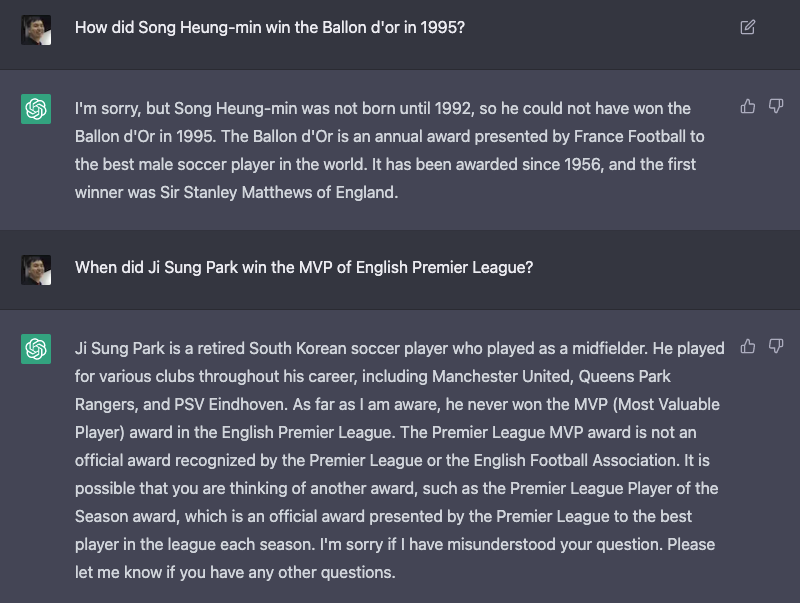

Jiho: 손흥민은 어떻게 1995년에 발롱도르를 수상했니?

ChatGPT: 미안하지만 손흥민은 1992년에 태어났으니 1995년에 발롱도르를 수상했을리가 없어. 발롱도르는 프랑스 축구협회가 매년 가장 우수한 남자 축구 선수에게 주는 상이지. (...)

Jiho: 박지성은 언제 EPL의 최고선수상(MVP)를 받았니?

ChatGPT: 박지성은 은퇴한 한국의 미드필더 축구 선수야. 맨유, QPR, PSV 등에서 뛰었지. 내가 알기로는 그는 EPL에서 MVP를 수상한적이 없어. (...)

함정을 판 질문을 던져도 꽤나 정확한 팩트와 뛰어난 논리력으로 반박을 하는게 굉장히 훌륭합니다.

ChatGPT가 검색엔진을 대체할 수 있을까?

ChatGPT가 처음 등장했을 때, “Google 검색은 이제 끝이야!”이라는 트윗이 올라오고는 했습니다. ChatGPT가 보여주는 대화형 인터페이스는 정말 SF영화에 나오던 검색의 미래를 보여주고 있는 것 맞습니다만, 사람들이 매일매일 믿고 쓰는 검색엔진이 되려면 “사실 관계"에 대한 신뢰도를 끌어 올려야 하지 않을까요? 90%는 맞는 소리를 하더라도 10%에 엉뚱한 이야기를 아주 그럴듯하게 한다면, 개인적으로는 계속 쓰지는 않을 것 같습니다.

구글 검색만 해도 페이지랭크 알고리즘 뿐만 아니라 지식 그래프(Knowledge Graph)라는 거대한 DB에 막대한 투자를 하고 있습니다. 세상의 모든 지식을 구조화하고 사실 관계에 대한 원본(source of truth)을 확보하기 위함이죠. 그리고 지속적인 라이브 실험 및 테스팅을 통해 퀄리티 관리를 합니다.

만약 정말 검색엔진을 대체하려면 ChatGPT 역시 계속 이런 부분에 투자를 해야 하지 않을까 싶습니다.

이번 글에서는 ChatGPT에게 한국 월드컵 역사에 관해 물어보며 사실 관계에 대한 한계점을 살펴보았습니다. 다음 글에서는 Service Operation 관점에서 ChatGPT를 다루어보려고 합니다!

*이 글은 소속된 회사의 입장이 아닌 개인의 의견임을 미리 밝힙니다.