Week 34 - 즉흥 연극 기법으로 AI 챗봇을 학습시킨다면?

<위클리 NLP>에서는 지난 몇 주 동안 AI 챗봇에 대해서 다루면서 구글, 페이스북, OpenAI 같은 거대한 기업들의 연구를 많이 인용해왔습니다. 이러한 큰 기업들은 거대한 데이터와 엄청난 컴퓨팅 파워를 가지고 있기 때문에 스케일이 큰 혁신을 이루는 데 우위가 있고, 그 결과에 따른 관심도 많이 받고 있습니다.

물론 이러한 선도적인 대기업들의 연구를 살펴 보는 것도 중요하지만 더 나은 AI 챗봇을 만들기 위한 크고 작은 노력은 이곳저곳에서 많은 연구자들에 의해 이루어지고 있습니다. 특히 비교적 리소스가 적을 수 밖에 없는 대학에서 재밌는 연구가 나오는 경우도 많은데요. 저도 대학원생 생활을 했던 입장에서 비교적 주목은 덜 받지만 이 분야의 원동력인 대학들의 연구에 대해 특별히 다루어보고 싶습니다.

이번 편에서는 특별히 AI 챗봇 연구를 하고 있는 박사생 조현동 군과 무척 재밌는 방향의 연구에 대해 알아보겠습니다.

박지호(이하 박): 자기소개 부탁합니다.

조현동(이하 조): 안녕하세요, 위클리 NLP 구독자 여러분! 저는 현재 University of Southern California(USC)에서 컴퓨터과학 전공으로 박사과정을 밟고 있는 조현동이라고 합니다. 저는 자연어처리 관련 연구를 하고 있고, 세부적으로는 오픈 도메인 챗봇, 즉 특정 주제에 제한 되지 않은 채로 최대한 오래 유저와 흥미로운 대화를 하는 시스템에 관한 연구를 하고 있습니다. USC를 오기전에는 홍콩과기대에서 컴퓨터 과학으로 학사를 졸업하고 USC Information Sciences Institute이라는 연구기관에서 Programmer Analyst로 1년간 일했습니다.

박: ACL 2020에 발표한 “Yes, and-” 챗봇과 데이터 셋에 대해서 소개해주세요. 기존의 챗봇은 어떤 문제점이 있나요? 어디서 영감을 받은 것인가요?

조: 즉흥 연극에서는 대본과 소품이 없는 상황에서 배우 간의 효율적인 grounding (공통된 세계관을 확립)을 격려하기 위해 즉흥적인 대사가 “Yes, and-” 원칙을 따라야합니다. 이 원칙 덕분에 즉흥 연극은 일상보다 좀 더 짜임새 있고 개연성이 있는 대화가 이루어진다는 것을 알 수 있습니다.

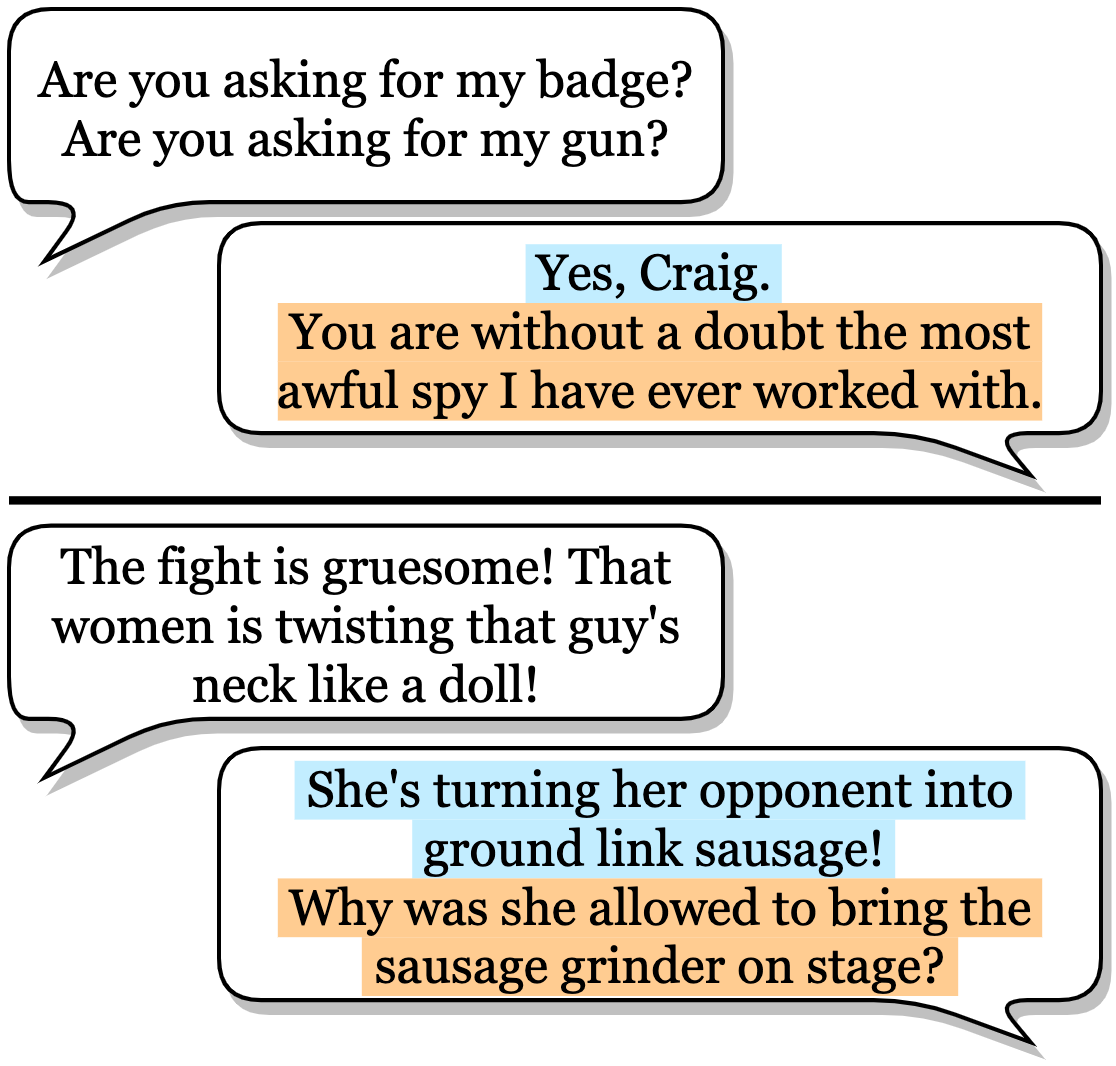

여기서 Grounding이란, 사람 사이에 효과적인 소통을 위해 필수적인 공통 된 이해와 기반을 다지는 과정을 뜻합니다. 예를 들면 “비가 오네"라는 말을 듣고 고개를 끄덕이거나 “빗물이 떨어진다”라고 의역을 하는 것도 grounding의 한 방법이죠. 다른 배우가 “싫어. 지금 화창한데?”라고 하면 함께 세계관을 형성하지 못하고 연극의 흐름을 깨겠죠. 반면 “우산이 없으니 편의점에서 사자."라고 대답하면 비가 오고 있다는 제안을 우산이 없다는 말로 수용하고 우산을 사야된다라는 정보를 제공하기 때문에 적절한 “Yes, and-”식 대사가 됩니다.

이 중 가장 능동적인 grounding은 ‘개연성 있는 기여’를 하는 것입니다. “비가 오네"에 대해 “널어놓은 빨래가 젖기 전에 치우자"라고 하는 것은 이전의 다른 반응과는 다르게 수동적으로 정보를 받아들이기만하지 않고, 관련 있는 새로운 정보를 제공함으로써 “비가 온다”라는 말에 대해 한층 더 깊은 이해력을 나타냅니다.

조: 기존 챗봇들은 이런 grounding을 직접적으로 학습하지 않았기 때문에 원활한 소통에 있어서 능동성이 부족하며 “예/아니오” 혹은 “모르겠어요"와 같이 말은 되지만 대화를 잇기 힘들게 만드는 대꾸를 자주 합니다. 저는 제 지도 교수님의 ‘즉흥 연기를 할 수 있는 챗봇을 만들 수 있을까?’라는 아이디어로부터 즉흥 연극에 관심을 갖고 자세히 알아보던 중, “Yes, and”라는 원칙을 통해 grounding이 활발하게 이뤄지고 있다는 것을 알게 됐습니다.

“Yes, and-” 원칙을 따르는 대화를 학습한 챗봇이 기존의 챗봇보다 대화를 이어나가는데 있어 상대의 말에 더 수용적이고 흥미로운 새로운 정보를 제공할 것이라는 가설을 기본적으로 시험해보기 위해 일단 “Yes, and-”식 대화를 즉흥 연극 팟캐스트 데이터셋으로부터 수집했습니다.

그리고 “Yes, and-”식 대화 턴들을 모아서 BERT 모델을 finetuning해서 “Yes, and-” classifier을 만들고, 이 classifier로 이미 존재하는 비슷한 도메인의 영화 데이터셋에서 데이터를 더 확장했습니다. 이 과정을 여러 번 반복하여 최종적으로 대략 68,000개의 “Yes, and-”식 대화 쌍으로 구성된 이 데이터셋은 즉흥 연극의 어머니라 불리는 Viola Spolin의 이름을 따서 Selected Pairs Of Learnable ImprovisatioN (SPOLIN)이라 지었습니다.

기존 대화 데이터셋들과 SPOLIN으로 다양한 조합을 이뤄 여러 GPT-2 모델을 finetuning하고 이 모델들을 다양한 대사에 대답하게 한 결과, SPOLIN을 함께 학습한 모델이 평균적으로 가장 적절한 “Yes, and-”식 답을 생성 했습니다. 많은 사람들이 SPOLIN으로 학습한 챗봇을 경험할 수 있도록 최근에 나온 DialoGPT 모델을 finetuning해서 SpolinBot이라는 데모를 만들었습니다. 관심 있으신 분은 justin-cho.com/spolin에서 실제 사용자들이 챗봇과 주고받은 재밌는 대화들을 찾으실 수 있습니다.

박: 최근 챗봇 연구자들은 어떠한 방향으로 발전하고 있나요? 본인이 관심있는 분야는 무엇인가요?

조: 요즘 오픈 도메인 챗봇과 관련해서 가장 많이 보이는 연구 방향은 (1) 지식 그래프나 데이터베이스에 내포 되어있는 외부 정보 (external knowledge)와 (2) 글로 표현되지 않아도 경험을 통해 모든 사람들이 공유하고 있는 기본 상식(common sense)을 대화 생성에 접목 시키는 것입니다. (필자: 지난 글에 다룬 지식 기반 챗봇 참고) 이 외에도 대화를 통한 지속적 학습(continual learning)이나 일관적인 성격을 띄는 성격-지향적 (personality-oriented) 챗봇도 많은 관심을 받고 있는 분야입니다.

최근에 ACL 2020에서 Bender와 Koller가 Climbing Towards NLU라는 논문을 통해 ‘문어 실험'이라는 흥미로운 가정 상황을 빗대어 외부 신호 (external signal) 없이 글만 보고 학습한 모델들은 단어나 문장들이 표현하는 실제 ‘의미’를 배우지 못하고 수면 위로 드러나는 형태를 모방할 뿐, 즉 지능을 가진 것처럼 보이는 것이 실제 지능을 가지고 있는 것은 아니다라고 주장했습니다. 실제로 GPT-3와 같이 우스갯소리로 ‘인터넷 전체를 가지고 학습한 모델’도 다양한 한계점들이 보이면서, 챗봇 관련 연구 뿐만 아니라 여러 자연어처리 세부분야에서 글 외의 외부적인 신호를 어떻게 활용해서 현재 한계점들을 넘어설 수 있을까라는 생각을 기반으로 한 연구들이 늘고 있습니다.

이와 같은 맥락으로 EMNLP 2020에서 Bisk et al.은 Experience Grounds Language라는 논문을 통해 인공지능을 기반으로한 자연어처리가 더 발전하기 위해서는 경험을 통해 언어를 배워야한다고 말하고 있습니다. 시각과 청각 같은 다른 양상(modality)을 활용해서 “눈은 하얗다”거나 “목소리를 높이다”와 같은 문장을 상응하는 외부 신호와 연결 시켜 학습해야 비로소 그 의미를 진정으로 이해할 가능성이 생긴다는 뜻입니다. 더 나아가 사람은 언어를 언어 모델링이라는 단편적인 과제가 아닌 목적을 위한 소통을 통해 배우기 때문에 인공지능도 상호작용과 피드백이 있는 환경에서 학습을 해야한다고 말하고 있습니다. 예를 들면 로봇이나 에이전트가 어느 불확실한 상황에 놓였을 때 특정 기능을 수행하기 위해서 적절한 질문으로 필요한 정보를 유저에게서 능동적으로 이끌어내는 것처럼 말이죠.

저도 Bender & Koller 그리고 Bisk et al.이 주장한 것처럼 언어는 글만으로는 배울 수 없다는 직관에 동의하기 때문에, 경험을 통해 언어의 의미를 배워서 현재 한계점들을 극복하는 연구에 관심이 많습니다. 아직 구체적인 연구 계획은 구상 중이지만, 큰 틀에서는 현재 인공지능 모델이 언어를 배우는 과정과 인간이 언어를 배우는 과정의 간극을 줄여서 향상된 NLU가 기반이 된 오픈 도메인 챗봇을 만들고 싶습니다. 지금은 많이 부족한 박사과정 1년차라 목표가 거창한데 일단 이 목표를 향한 현실적이고 세부적인 연구 과제들을 찾아야죠!

박: Amazon Alexa Prize Socialbot Grand Challenge 4에 경쟁하게 될 9개의 팀 중 하나로 선정되었는데, 대회에 대한 소개, 그리고 팀과 프로젝트에 대해서 알려주세요.

조: Amazon Alexa Prize Socialbot Grand Challenge는 아마존에서 2016년부터 매년 기획한 음성 기반 오픈 도메인 챗봇을 만드는 대회입니다. 사용자 평균 평점에 따라 다음 라운드로의 진출 여부가 결정되며, 최종전에서는 전문가 평가와 사용자 평균 평점을 도합한 점수로 우승자를 가립니다. 대회 우승과 별개로 Grand Prize 수상 조건은 사용자들로부터 평점 5점 만점에 평균 4점 이상을 받고 전체 대화의 2/3의 지속 시간이 20분을 넘는 것인데, 작년 우승 팀이 평균 3.7점 정도에 대화 시간은 8분 남짓인 것을 감안하면 상당히 어려운 조건입니다. 평점이란 것은 유저들의 주관이 많이 담겨있기 때문에 기대치에 따라 4점을 넘는 것이 가능해보이지만 비교적 객관적인 대화 시간에 있어서 20분에 다다르기까지는 갈 길이 많습니다.

오픈 도메인 챗봇 대회인만큼 몇가지 규율을 제외하고는 챗봇을 디자인하고 구현하는데 있어서 자유롭습니다. 욕설, 인종차별적인 표현, 예민한 주제와 관련해서 극단적인 발언, 등 문제가 될만한 발언을 하지 않고 사용자에게 흥미롭거나 유익한 경험을 주어서 좋은 평점을 받는다면 아무 주제에 대해서 얘기해도 됩니다.

조: 저는 USC 대표로 선정된 팀 Viola의 리더로 저의 지도 교수님인 Jonathan May 교수님과 저를 포함한 5명의 석박사생으로 구성된 팀을 이끌고 이 대회에 처음으로 참가하게 됐습니다. 저희 학교에서 Alexa Prize를 참가하는게 올해가 처음인데다 코로나 바이러스로 인해 원격으로만 지원을 받아서 합류 과정이 쉽지는 않았지만, 저희가 만든 챗봇으로 실제 사용자들의 데이터를 수집하고 평가를 받는다는 것이 유익한 경험이 되고 있습니다. 작년 우승팀은 finite state machine (FSM)을 최대한 활용해서 이미 구상해놓은 대화 흐름을 사용자가 따라가게 만드는 방식을 선택했는데, 저희는 확장이 쉽지 않은 FSM에 대한 의존도를 최소화하기 위해 꼭 필요한 부분에만 FSM을 사용하고 미리 구상하지 않은 주제에도 적절한 대응을 할 수 있도록 인공 신경망을 기반으로한 모델들을 활용하려고 노력 중에 있습니다.

Alexa Prize에 대한 더 자세한 정보는 홈페이지에서 찾아보실 수 있습니다. 혹시 알렉사 앱이나 알렉사 기기를 소유하신 분은 심심하실 때 “Alexa, let’s chat”이라고 알렉사에게 말을 걸어주시면 9개의 팀 중 하나의 봇과 대화를 나눠주시고 대화가 끝나고서는 간단하게 평가해주시면 감사하겠습니다!

<조현동 군에게 더 궁금한 점이 있다면>

jcho@isi.edu

justin-cho.com

시간내서 본인의 연구와 생각을 공유해준 조현동 군에게 감사의 말씀을 드립니다.

기업에선 Gradient Descent를 하지만, 대학에선 Graduate student Descent (해석: 대학원생을 갈아서 연구 결과를 낸다) 한다는 머신러닝 PhD 농담이 있을 정도로 전세계에 많은 대학원생들이 이 분야 혁신을 위해 뛰고 있습니다. 창의성은 제약이 있을 때 더 발휘될 수 있기에 이처럼 대학에서 나오는 NLP 연구도 종종 다룰 수 있었으면 좋겠습니다.

혹시 본인의 일이나 연구에 대해서 이러한 형식 협동 컨텐츠로 다루고 싶다면 댓글이나 이메일로 연락(jiho@jiho-ml.com)주시길 바랍니다! 그리고 독자분들은 이 새로운 포맷의 글은 어떻게 읽으셨는지 댓글로 피드백 남겨주시면 감사하겠습니다.

REFERENCE

- Grounding Conversations with Improvised Dialogues, Cho & May, ACL 2020

- Zhang, Yizhe, et al. "DIALOGPT: Large-Scale Generative Pre-training for Conversational Response Generation, ACL 2020

- Bender, Emily M., and Alexander Koller. "Climbing towards NLU: On meaning, form, and understanding in the age of data.", ACL 2020

- Bisk, Yonatan, et al. "Experience Grounds Language." EMNLP 2020.